大数据治理 关键能力与核心技术支撑

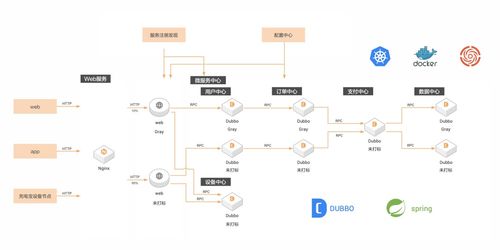

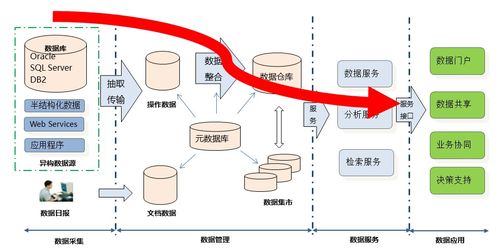

大数据治理是确保数据资产质量、安全性和可用性的系统性工程,旨在将海量、多源、异构的数据转化为可信、可用的战略资源。它需要一系列综合能力与关键技术作为支撑,特别是在数据处理和存储服务层面。

一、 大数据治理需具备的核心能力

1. 战略与组织能力:

需要建立清晰的治理战略,明确数据所有权、管理职责和决策流程。这包括设立跨部门的数据治理委员会,制定统一的数据政策、标准和流程,并确保其与业务目标对齐。

2. 数据架构与建模能力:

能够设计并维护企业级数据架构,包括概念模型、逻辑模型和物理模型,确保数据定义的一致性和数据流动的合理性。这是实现数据集成、共享和高质量分析的基础。

3. 数据质量管理能力:

贯穿数据全生命周期的核心能力,包括数据剖析、清洗、标准化、验证和持续监控。目标是确保数据的准确性、完整性、一致性、时效性和唯一性,从而建立对数据的信任。

4. 数据安全与隐私保护能力:

在日益严格的法规(如GDPR、个保法)要求下,必须建立数据分类分级、访问控制、加密、脱敏、审计和防泄露机制,平衡数据利用与安全合规。

5. 元数据与主数据管理能力:

元数据是“关于数据的数据”,管理好业务、技术和操作元数据是实现数据可发现、可理解、可追踪的关键。主数据管理则确保核心业务实体(如客户、产品)数据的单一、准确版本。

6. 合规与风险管理能力:

能够识别并管理数据相关的法规、合同和伦理风险,建立合规性检查与报告机制,使数据活动始终符合内外部要求。

二、 支撑数据处理与存储服务的关键技术

大数据治理的落地,离不开底层强大的数据处理与存储技术栈。这些技术是能力实现的具体载体。

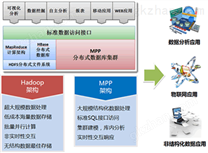

在数据处理层面,关键技术包括:

- 批流一体的计算框架:如Apache Spark,它提供了强大的内存计算能力,支持大规模的批处理和微批处理,是ETL(抽取、转换、加载)和数据加工的核心引擎。

- 实时流处理技术:如Apache Flink、Apache Kafka Streams,它们能对无界数据流进行低延迟、高吞吐的处理,满足实时监控、实时决策和事件驱动架构的需求。

- 数据集成与同步工具:如Apache NiFi、DataX、Debezium等,负责在不同数据源与数据仓库/湖之间高效、可靠地移动和同步数据。

- 数据质量工具:如Great Expectations、Apache Griffin、Deequ,它们通过定义规则和约束,自动化地进行数据质量校验和监控。

- 工作流调度与编排:如Apache Airflow、DolphinScheduler,用于编排复杂的数据处理管道,确保任务依赖正确、执行有序、故障可恢复。

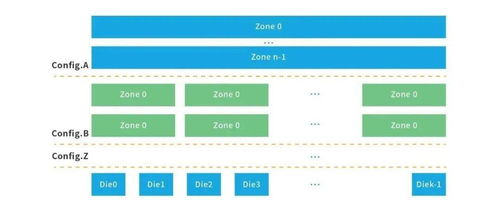

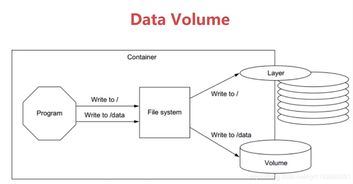

在数据存储服务层面,关键技术包括:

- 分布式文件系统:如Hadoop HDFS,提供高容错性、高吞吐量的海量数据存储基础。

- 对象存储服务:如AWS S3、阿里云OSS、华为云OBS,因其近乎无限的扩展性、高耐久性和成本效益,已成为数据湖存储的事实标准。

- 多模数据库与数据仓库:

- 数据仓库:如Snowflake、阿里云MaxCompute、ClickHouse,面向结构化数据,为复杂的BI分析和报表提供高性能、强一致的查询服务。

- 数据湖:基于对象存储构建,如Delta Lake、Apache Iceberg、Apache Hudi,它们在原始数据之上提供了表格式(Table Format),为数据湖带来了ACID事务、模式演进、时间旅行等数据仓库般的管理能力,形成“湖仓一体”架构。

- NoSQL数据库:如HBase(宽列)、MongoDB(文档)、Neo4j(图),用于处理非结构化或半结构化数据,满足特定场景的低延迟读写和灵活模型需求。

- 统一元数据与数据目录服务:如Apache Atlas、DataHub、Amundsen,它们像数据的“搜索引擎”和“地图”,自动采集技术元数据,并关联业务术语、数据负责人和质量信息,是提升数据可发现性与可信度的中枢。

###

大数据治理是一个“管理”与“技术”双轮驱动的过程。上述能力和技术并非孤立存在,而是相互关联、协同作用的。一个成功的大数据治理体系,需要将这些能力融入组织文化,并通过精心选择和集成的技术栈来实现,最终构建一个安全、合规、高质量、易用的数据资产底座,从而充分释放大数据价值,驱动业务智能与创新。

如若转载,请注明出处:http://www.aijiasichu.com/product/27.html

更新时间:2026-01-13 15:50:08